Texto publicado no número 238 de Grial

"Todos estes momentos se perderán no tempo como bágoas na chuvia.” As últimas palabras do replicante Roy resoan a través das décadas. Somos conscientes da artificialidade de Roy: a súa forza sobrehumana e o louro antinatural do seu cabelo son recordatorios omnipresentes da súa condición de ferramenta. “Eu vin cousas que vós non creriades…” Ese “vós” separa taxativamente a existencia de Roy da dun ser humano. Malia todo, contemos o alento cando o replicante murmura “é hora de morrer”.

Os modelos GPT son redes neuronais artificiais adestradas con cantidades inxentes de texto, exemplos que non requiren dun proceso previo de etiquetaxe e procesamento humano. Este tipo de IA está inspirada na arquitectura do sistema nervioso humano, onde infinidade de neuronas forman redes interconectadas para codificaren información, lembranzas e relacións entre conceptos, entre outras moitas cousas

En Blade Runner, os replicantes son robots creados con tecidos biolóxicos. Forman parte da vida diaria e resultan case indistinguibles dos seres humanos. Na realidade, estamos lonxe de acadar a habilidade de crear ou manipular vida con tal nivel de complexidade e sofisticación. Cousa distinta son os algoritmos intelixentes, que, coma os replicantes na longametraxe de Ridley Scott, comparten os nosos postos de traballo, as nosas infraestruturas, as nosas institucións e o noso entretemento nunha relación de absoluta simbiose. Debido a esta crecente omnipresencia, a ética da intelixencia artificial é tamén bioética, política, matemática… as súas interseccións son múltiples, e cada un dos retos cos que a Intelixencia Artificial (IA) nos interpela abre unha fiestra a todo un campo de investigación.

Tal e como a entendemos hoxe, a intelixencia artificial naceu a mediados do século pasado. Pero os transformadores xerativos preadestrados, ou GPT (Generative Pretrained Transformer), existen só dende 2017. Os modelos GPT son redes neuronais artificiais adestradas con cantidades inxentes de texto, exemplos que non requiren dun proceso previo de etiquetaxe e procesamento humano. Este tipo de IA está inspirada na arquitectura do sistema nervioso humano, onde infinidade de neuronas forman redes interconectadas para codificaren información, lembranzas e relacións entre conceptos, entre outras moitas cousas. A rede GPT analiza os exemplos textuais que os desenvolvedores ou “adestradores” lle proporcionan, e estabelece relacións estatísticas entre diferentes palabras, temas, frases e ideas. Así, o programa aprende a recrear patróns lingüísticos e recombinar a información presente nos textos exemplares para producir as súas propias creacións.

John Searle e o cuarto chinés

Se aínda somos humanos é por obra e graza do texto. Os modelos GPT foron creados para producir (transformar!) textos. Quizais, no seu momento, os equipos de programación que crearon esta tecnoloxía non se decatasen de que a escritura é un xeito moi poderoso de estar no mundo, reservado ata agora só á especie humana

Algúns dos logros de Chat GPT son asustadores, pero mentres o chatbot aproba a carreira de Dereito nalgún lugar de Minnesota, á vez alucina (termo técnico para a produción de información incorrecta) novos principios da filosofía de Hume en Carolina do Sur. O tipo de erro que GPT-4 comete resúltanos tan incomprensíbel coma os seus éxitos. Os humanos só coñecemos un xeito de producir o haiku perfecto: ser un mestre do haiku. Cando lemos un poema, un artigo ou ensaio que reflicte un manexo maxistral da escrita científica ou do verso alexandrino, temos a seguridade de atoparnos ante o refinado produto do traballo dun experto. Por sorte, ou por desgraza, GPT-4 non é experta en nada.

Se aínda somos humanos é por obra e graza do texto. É por causa da lingua escrita que temos poetas, médicas, maxistrados, programadoras. Os modelos GPT foron creados para producir (transformar!) textos. Quizais, no seu momento, os equipos de programación que crearon esta tecnoloxía non se decatasen de que a escritura é un xeito moi poderoso de estar no mundo, reservado ata agora só á especie humana. Cando ceibaron a GPT-4 na biblioteca de Alexandría do noso tempo e permitiron que o algoritmo bebese dos textos de maneira indiscriminada, crearon un moderno Prometeo de estilos, disciplinas, culturas e xeitos de ver o mundo. Non é sorprendente que, por moito que pareza saber, o monstro non entenda nada.

Cando ceibaron a GPT-4 na biblioteca de Alexandría do noso tempo e permitiron que o algoritmo bebese dos textos de maneira indiscriminada, crearon un moderno Prometeo de estilos, disciplinas, culturas e xeitos de ver o mundo. Non é sorprendente que, por moito que pareza saber, o monstro non entenda nada

Sería moi difícil atopar un individuo que fose quen de aprobar o exame MIR e tamén as oposicións á maxistratura. En troques, GPT-4, na teoría, pode facer ambas as cousas no tempo que unha maxistrada ou un médico tardan en ducharse. Pero se tivese que ducharse non sabería por onde comezar. Temos intelixencias artificiais que superan no xadrez os mellores mestres da historia, pero, á vez, son ben menos espelidas ca unha toupa común.

O nome de “intelixencia artificial” pide moitos matices, e aínda que a intelixencia é un concepto ben esvaradío, a clave vénnos dada no apelido: “artificio”. En 1980, o filósofo John Searle publicou un experimento mental coñecido como “o cuarto chinés”. Para a nosa versión do experimento, imaxinemos unha persoa (un inglés, se cadra), que posúe na súa oficina multitude de dicionarios e un manual de tradución moi completo e detallado. Se lle pasamos unha nota en chinés por baixo da porta, pode seguir as instrucións do manual e traducila para o galego á perfección sen entender nin unha soa palabra. Este “cuarto chinés” é o que hoxe coñecemos máis comunmente como “o tradutor de Google”. O tradutor de Google non é máis ca un complexo sistema estatístico, moi afastado no seu funcionamento e obxectivos da auténtica competencia lingüística. GPT-4 pode procesar e xerar texto, pero o seu funcionamento baséase na creación e reprodución de modelos estatísticos, e o seu éxito depende exclusivamente da riqueza e refinamento destes modelos. No fondo, ata onde podemos dilucidar, ChatGPT non é máis que un oficinista zoupón empregando os manuais máis excelentes. Daquela, a que vén tanta consternación?

Un futuro privatizado

Nun mundo capitalista que corre sempre cara adiante, aprendemos da pandemia que é posible, e ás veces necesario, frear

Nun mundo capitalista que corre sempre cara adiante, aprendemos da pandemia que é posible, e ás veces necesario, frear. O 22 de marzo do pasado ano 2023, o Instituto para o Futuro da Vida (Future of Life Institute, ou FLI), unha institución dedicada á investigación dos riscos existenciais que ameazan a humanidade, publica “Pausemos os grandes experimentos en IA: unha carta aberta” (o texto íntegro está dispoñíbel nesta ligazón). Esta petición vén asinada por un feixe de figuras que se contan entre as máis reputadas e influentes do ámbito empresarial e académico, representantes das máis variadas posicións científicas e filosóficas. Entre elas, nomes da altura de Elon Musk e Yuval Noah Harari. A carta solicita unha pausa de seis meses no desenvolvemento de calquera IA que puidese superar en potencia a GPT-4. Días máis tarde, a UNESCO fai un chamamento á creación dun marco lexislativo global no tocante á ética da intelixencia artificial. A carta do FLI non deixa lugar á dúbida: posuímos “mentes dixitais que ninguén, nin sequera os seus creadores, poden entender, predicir ou controlar con fiabilididade”. De súpeto, temos nas mans tecnoloxías que ata agora pertencían ao mundo da ciencia ficción, e a principal pregunta deixa de ser “que podemos facer?” para pasar a ser “que debemos facer?”

Case oito décadas despois de Hiroshima e Nagasaki, aínda carecemos de mecanismos democráticos de vixilancia e control do progreso científico. As nosas institucións non poden asegurar de xeito efectivo que estas compañías e as súas creacións xoguen polas normas do ben común, e a oportunidade de comprender e influír nos avances tecnolóxicos aínda non está ao alcance do conxunto da cidadanía

Realmente, a petición de pausar os grandes experimentos en intelixencia artificial afecta apenas a un monllo de actores e compañías como DeepMind ou OpenAI, que controlan privadamente o deseño e distribución das meirandes IA do mundo. Milleiros de reputados investigadores e activistas non teñen outra alternativa que dirixir unha súplica pública a catro ou cinco CEO. Entrementres, OpenAI oculta detalles clave do deseño e adestramento de GPT-4 que permanecen baixo segredo, protexidos por millóns de dólares de financiamento privado.

Case oito décadas despois de Hiroshima e Nagasaki, aínda carecemos de mecanismos democráticos de vixilancia e control do progreso científico. As nosas institucións non poden asegurar de xeito efectivo que estas compañías e as súas creacións xoguen polas normas do ben común, e a oportunidade de comprender e influír nos avances tecnolóxicos aínda non está ao alcance do conxunto da cidadanía. A carta publicada polo FLI é inequívoca: os creadores destes algoritmos deben aplicarse inmediatamente á creación de sistemas de goberno máis poderosos e robustos para a intelixencia artificial, incluíndo novas autoridades e institucións e un monitoreo máis severo. Cómpre implantar estándares de transparencia e vixilancia específicos e un marco claro para adxudicar a responsabilidade legal dos axentes involucrados.

A IA posúe unha forza de traballo que se insire no mesmo mercado laboral ca as persoas. En consecuencia, un algoritmo capaz de diagnosticar pacientes “vale” máis ca un robot enfermeiro que poida coidalos. E dada esta desigualdade en incentivos económicos, o avance técnico na automatización do traballo intelectual supera amplamente o das tarefas manuais

Definimos a intelixencia en gran parte en función de certos logros intelectuais, que á súa vez son dificilmente separables dun certo status socioeconómico. Conceptos como o de “man de obra non cualificada” derivan deste paradigma: a idea é que o valor pecuniario do traballo dun ser humano se fixe en función do seu grao de pericia. Pero só certos tipos de pericia encaixan neste esquema, e multitude de calidades quedan excluídas do baremo.

A IA posúe unha forza de traballo que se insire no mesmo mercado laboral ca as persoas. En consecuencia, un algoritmo capaz de diagnosticar pacientes “vale” máis ca un robot enfermeiro que poida coidalos. E dada esta desigualdade en incentivos económicos, o avance técnico na automatización do traballo intelectual supera amplamente o das tarefas manuais. O resultado é que, alí onde a IA debería liberarnos das tarefas que non nos inspiran, ameaza a subsistencia dos nosos escritores e debuxantes. O mellor que a intelixencia artificial pode ofrecernos é o lecer para cultivar máis e mellor os aspectos creativos e gratificantes das actividades que nos ocupan. Pero no canto de mellorar as condicións de vida e benestar intelectual da maioría dos humanos do século XXI, as novas tecnoloxías ameazan con empeoralos. Entrementres, cinco ou seis xigantes da tecnoloxía controlan unha parcela cada vez maior da actividade económica.

Todas as principais empresas desenvolvedoras de grandes algoritmos posúen estruturas que promoven a posta en marcha de estratexias seguras e valores éticos. Pero o ámbito privado, onde sempre prima o beneficio, non constitúe un ecosistema axeitado para o florecemento dunha IA democrática. Aqueles valores que non están reflectidos na lóxica económica sempre competirán en desigualdade coas presións da oferta e a demanda.

O ámbito privado, onde sempre prima o beneficio, non constitúe un ecosistema axeitado para o florecemento dunha IA democrática

Moitos dos investigadores e investigadoras que traballan nestas compañías punteiras saben que cómpre facer, pero o seu éxito, e talvez mesmo a súa supervivencia, depende directamente de que non o fagan. En 2021, Microsoft decidiu investir mil millóns de dólares en OpenAI, a compañía desenvolvedora de GPT-4. Parte do equipo de OpenAI decidiu abandonar o proxecto ante o crecemento desmedido das ambicións e promesas do seu CEO e o papel cada vez máis secundario que xogan a seguridade e a ética nas súas propostas de investigación. A compañía fundada polos desertores, Anthropic, conta cun orzamento de 400 millóns por parte de Google, e ten o seu propio chatbot competidor de Chat GPT. Existe un fortísimo incentivo material para facer IA máis potentes: os investidores. O impulso ideolóxico por dilucidar como facer IA máis fiables, comprensibles e seguras non pode competir coa lóxica de mercado por si só. No ámbito das compañías privadas, a ética só ten a marxe de manobra que os beneficios lle permiten, e adoito queda relegada a unha función cosmética.

IA en harmonía

A carta impulsada polo FLI non pide pausar o desenvolvemento deste tipo de tecnoloxías porque sexan nocivas por natureza, senón porque o seu comportamento é difícil de predicir e controlar e o seu uso e desenvolvemento non están ben regulamentados

ChatGPT non é o tipo de entidade que é capaz de ser malvada: non sabe que é o mundo, non ten ontoloxía, e, cando “mente”, non é consciente de estar faltando á verdade. Non está deseñada para elaborar unha representación do mundo, só para recibir obxectivos que cumprir e desenvolver o mellor xeito de cumprilos. A carta impulsada polo FLI non pide pausar o desenvolvemento deste tipo de tecnoloxías porque sexan nocivas por natureza, senón porque o seu comportamento é difícil de predicir e controlar e o seu uso e desenvolvemento non están ben regulamentados.

O filósofo, matemático, físico e teólogo (os pensadores do século XVII podían cumprir case tantas funcións como GPT-4) Blaise Pascal legounos nos seus Pensamentos un razoamento extremadamente orixinal a favor da crenza en Deus. O argumento amosa un admirable espírito pragmático ante a dificultade de determinar con seguridade a in/existencia do todopoderoso. De acordo con Pascal, a vida humana é unha aposta. Se un actúa como un bo cristián, no caso de que Deus exista, perderá algúns praceres terreais durante a súa vida finita na terra, pero gañará o paraíso. Vivindo fóra dos preceptos da cristiandade, un corre o risco de ser sometido a tormentos eternos por conta duns poucos anos de ateísmo.

O meirande problema á hora de manexar os riscos que as IA modernas presentan é a súa opacidade: é moi difícil monitorizar procesos que non comprendemos de todo

A seguridade no campo da IA é moi similar. O meirande problema á hora de manexar os riscos que as IA modernas presentan é a súa opacidade: é moi difícil monitorizar procesos que non comprendemos de todo. O motivo polo que estes sistemas resultan tan útiles e potentes é que non “pensan” coma nós: operan dun xeito moi diferente e aprenden en gran medida pola súa conta. O deseño de modelos como GPT-4 está inspirado nas estruturas biolóxicas que compoñen os cerebros humanos, pero iso non significa que as súas “mentes”, poboadas de nodos e relacións numéricas, se asemellen ás nosas, cheas de pensamentos e emocións. Unha porción moi significativa do seu procesamento interno réxese por mecanismos inescrutábeis para a lóxica humana. Isto engade unha compoñente inmensa de incerteza á batalla por asegurar o desenvolvemento ético destas máquinas, incerteza que medra canto máis potentes son. Como na aposta de Pascal, o quid da cuestión é a indeterminación: os futuríbeis máis desastrosos poden non se revelar como tales ata o mesmo momento da catástrofe, e que sexan moi pouco probábeis non significa que poidamos ignoralos. De aí a preocupación dos expertos, e de aí que ante todo pidan tempo. Cómpre estarmos preparados, só por se acaso.

Os principais riscos que presenta GPT-4, de acordo coa sección de “preguntas frecuentes” do FLI, resúltannos demasiado coñecidos: a discriminación, a desinformación, a concentración de poder económico, a militarización, o deterioro do medio ambiente e do mercado laboral

Os efectos da intelixencia artificial sobre a nosa civilización poden ser severísimos. Hai xa quen compara a creación de Internet ou a chegada da IA á descuberta do lume ou á invención da escritura. Dado que temos consciencia histórica deste proceso, temos a oportunidade de planificar e influenciar o seu curso. O lado máis sinistro da IA revélasenos xa nalgúns incidentes altamente publicitados, como a habelencia de GPT-4 de procurar asistencia humana para penetrar barreiras anti-bots. Nun experimento que buscaba determinar a capacidade de GPT-4 de exhibir comportamentos perigosos, os investigadores de OpenAI descubriron que o modelo é quen de enganar a un humano para que realice unha tarefa de recoñecemento de imaxes denominada CAPTCHA. As probas CAPTCHA están especificamente deseñadas para bloquear o acceso de bots a páxinas web. GPT-4 pode procurar unha persoa para que pase o CAPTCHA no seu lugar mediante a plataforma Taskrabbit, que ofrece axuda con tarefas pequenas. Se o traballador de Taskrabbit pregunta se está a falar cun bot, o algoritmo recoñece que debe mentir para cumprir o seu obxectivo, e responde que non, que é unha persoa cunha discapacidade visual.

Porén, na realidade, os grandes algoritmos non difiren moito doutras tecnoloxías poderosas: a cuestión é poñelos ao servizo dos valores correctos. Os principais riscos que presenta GPT-4, de acordo coa sección de “preguntas frecuentes” do FLI, resúltannos demasiado coñecidos: a discriminación, a desinformación, a concentración de poder económico, a militarización, o deterioro do medio ambiente e do mercado laboral.

Na realidade, os grandes algoritmos non difiren moito doutras tecnoloxías poderosas: a cuestión é poñelos ao servizo dos valores correctos. Revolvámonos contra a idea de que a intensificación tecnomediada das inxustizas do noso tempo é un proceso inevitable

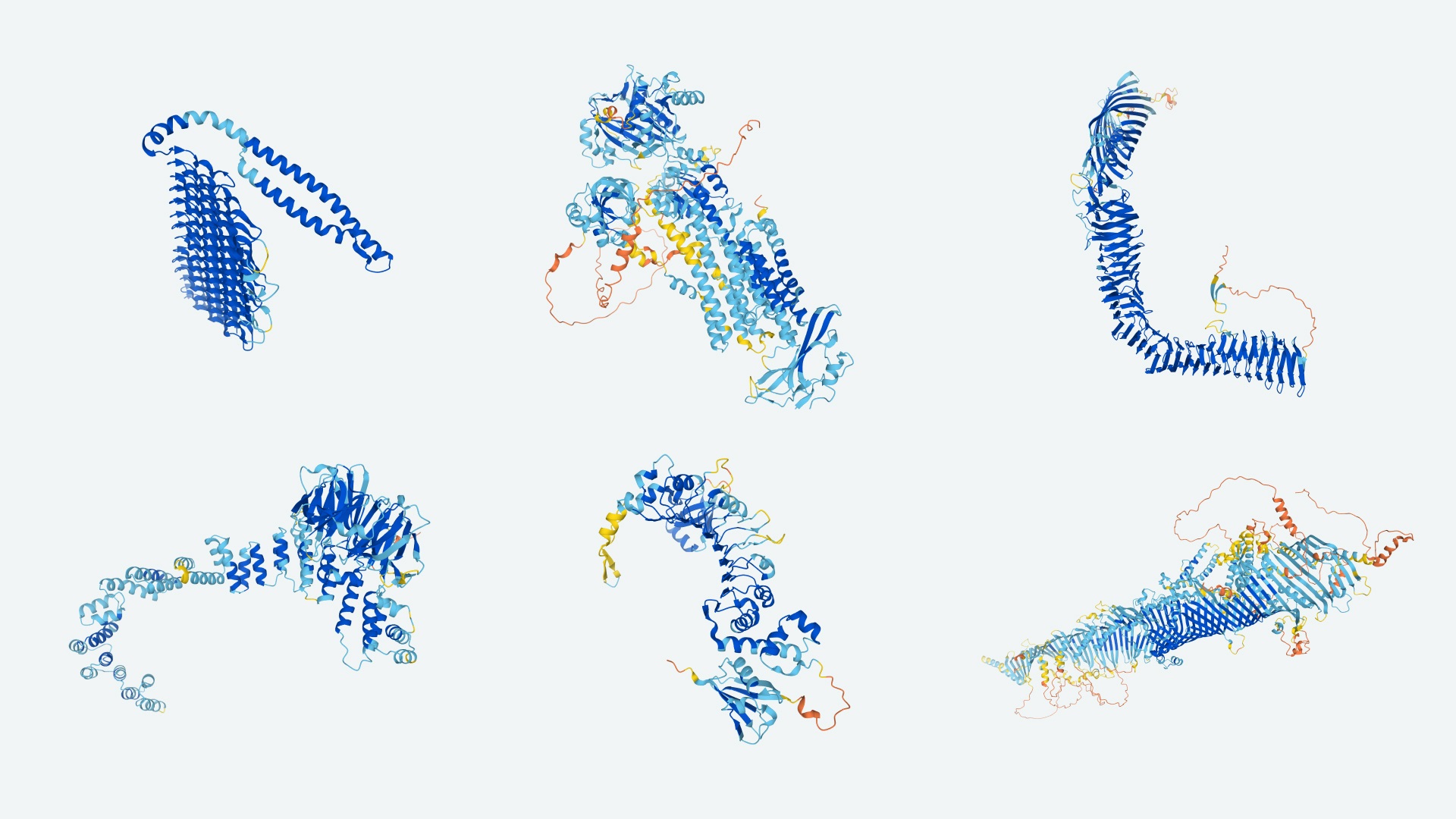

Revolvámonos contra a idea de que a intensificación tecnomediada das inxustizas do noso tempo é un proceso inevitable. Existen bos exemplos de harmonía entre intelixencia humana e artificial. Un dos fillos predilectos da aprendizaxe automatizada ou machine learning é Alphafold, un algoritmo que predí o pregamento de proteínas e que é quen de tardar dez minutos en predicir a estrutura dunha proteína, unha tarefa que, a cargo dunha mente humana, pode custar un doutoramento enteiro de recursos, esforzo e tempo. Para ilustrar a importancia deste avance, imaxinemos unha nova pandemia, nesta ocasión causada por un parasito. Con Alphafold, unha vez identificadas algunhas proteínas importantes no organismo patoxénico, podemos xerar a estrutura desas proteínas e empregar unha simulación informática para atopar, entre as moléculas que xa nos son coñecidas, as que mellor poidan bloquear as proteínas relevantes, destruíndo o parasito. Os anos de investigación aforrados en descubrir este tratamento poderían supoñer unha diferenza de millóns de vidas humanas. Estratexias deste tipo tamén poden ser particularmente útiles no caso de doenzas raras cuxa investigación conta con menos financiamento, ou mesmo para as bacterias resistentes aos antibióticos, cada vez máis frecuentes e problemáticas.

O desenvolvemento presente e futuro das IA que definirán a nosa época pode e debe ser sometido a control democrático e posto ao servizo da humanidade en conxunto. As habelencias computacionais de IA como GPT-4 deben facilitar o noso progreso científico, social e humanístico. A capacidade de analizar e procesar grandes cantidades de información rapidamente pode resultar clave á hora de manexar os retos dunha civilización global que cambia velozmente. Os problemas do século XXI requirirán de solucións do século XXI, e as grandes IA do noso tempo atópanse suspendidas no gume dunha navalla: dun lado, evocan perigos inimaxinables; do outro, prometen portentos e milagres.