Texto publicado no número 241 de Grial

A Intelixencia Artificial (IA) está presente cada día nos medios de comunicación. Moitas veces de forma equivocada, esaxerada ou mesmo distópica. Isto é moi negativo, xa que provoca desinformación, deformación da realidade e, o que é peor, unha alarma innecesaria, que ademais pode distraernos do que si é real e xa ocorre agora

A Intelixencia Artificial (IA) está presente cada día nos medios de comunicación. Moitas veces de forma equivocada, esaxerada ou mesmo distópica. Isto é moi negativo, xa que provoca desinformación, deformación da realidade e, o que é peor, unha alarma innecesaria, que ademais pode distraernos do que si é real e xa ocorre agora.

As tecnoloxías intelixentes son as máis transformadoras de cantas ideamos, é certo, e nin todo é bo nin todo vale cando falamos de desenvolver e aplicar a intelixencia artificial. As organizacións e, sobre todo, os Gobernos, deben ter claros os límites, e estes temos que expoñelos e ata esixilos nós, os cidadáns. Para iso é importante ter unha información clara e veraz, e aí non deberían ter cabida as mensaxes de ignorantes, oportunistas ou con malas intencións.

Neste artigo expoñeremos algunhas das afirmacións sen fundamento, ou cando menos esaxeradas, coas que nos bombardean, e daremos razóns para poñelas no seu sitio.

Esaxeracións?

A IA está lonxe, moi lonxe, de desenvolver a conciencia ou a intención maliciosa que se describe nos libros e nas películas de ciencia ficción. Tampouco a IA ten obxectivos que non fosen fixados nin inducidos polos seus deseñadores; a súa capacidade é moi limitada neste sentido. Os sistemas de IA son ferramentas creadas e controladas por humanos

Que pensaría de alguén que afirmase que unha intelixencia artificial desenvolveu conciencia propia? Blake Lemoine dixo que o modelo LaMDA (Language Model for Dialogue Applications) desenvolvido por Google, empresa na que entón traballaba, era “sentinte” e que, por tanto, deberíanse respectar os seus “desexos”. Google negou tales afirmacións e despediuno. Isto ocorreu en xuño de 2022.

Que opinaría se o CEO de OpenAI, unha das compañías líderes a nivel mundial en IA, afirmase que o seu peor medo é que esta tecnoloxía saia mal, e que “se sae mal, pode saír moi mal”? Sam Altman fixo estas declaracións ante o Senado estadounidense en maio de 2023.

Que diría se un dos investigadores máis relevantes en IA renunciase ao seu traballo como vicepresidente de enxeñería nunha das empresas máis grandes do mundo tecnolóxico, advertindo dos crecentes perigos que poden ocasionar os avances neste campo? Trátase de Geoffrey Hinton, e a compañía tamén é Google. Hinton fixo algunhas das máis brillantes contribucións no ámbito das Redes Neuronais Artificiais e a aprendizaxe profunda. En maio de 2023 anunciou a súa dimisión de Google, afirmando que se arrepentía do seu traballo na compañía. Nunhas declaracións á BBC dixo dos grandes modelos de linguaxe: “Agora mesmo non son máis intelixentes ca nós, polo que eu sei. Pero creo que pronto poderían selo”.

E se a persoa máis rica do mundo, multiemprendedor en sectores tecnolóxicos de vangarda, describise a IA como “potencialmente a maior ameaza contra a civilización”? Así foi. Son declaracións de Elon Musk, realizadas o 18 de setembro de 2023.

Obviamente, se deixamos en mans dunha IA a capacidade de tomar decisións autónomas que poidan danarnos, por acción ou por omisión, poderiamos ter moitos desgustos. Canto máis capaz é unha tecnoloxía e máis elementos críticos deixemos baixo o seu control, máis dano pode facer no caso de que o seu funcionamento non sexa o adecuado

Stephen Hawking alertou tamén sobre a IA, dicindo que “Conseguir crear unha Intelixencia Artificial pode ser o maior logro histórico da humanidade. Pero tamén pode ser o último, se non acertamos a evitar os seus riscos”. Hawking pensaba que será posible chegar a unha IA cunha intelixencia equivalente á humana nun centenar de anos, situando a súa predición, iso si, nun prazo de tempo no que nunca se lle poderían pedir explicacións de non cumprirse. Nós opinamos o mesmo, por certo.

Salvo a reflexión de Hawking, o resto das frases son esaxeradas, cando non apocalípticas, máis que nada porque non falan dun futuro hipotético no que unha IA sobrehumana poida chegar a expor riscos existenciais para a humanidade, senón que se refiren ao presente ou a un mañá ao virar a esquina. Sen dúbida, son afirmacións que sobreestiman as capacidades da IA actuais ou a enorme distancia que aínda a separa de alcanzar unha IA xeral, un camiño que no mellor dos casos será moi longo, pero que, sobre todo, non sabemos por onde trazalo.

Dito isto, é evidente que as persoas que citamos non son precisamente ignorantes do discorrer da IA, do seu estado actual e das expectativas razoables que poida haber sobre o seu desenvolvemento futuro. Pero, como os pescadores, todos esaxeramos ás veces, sexa polo motivo que sexa.

A IA está lonxe, moi lonxe, de desenvolver a conciencia ou a intención maliciosa que se describe nos libros e nas películas de ciencia ficción, en particular naquelas con visións distópicas, onde as máquinas (robots, en xeral), acaban connosco. Realmente téntano, pero nunca o conseguen, xa que nos gusta que nas películas sempre gañen os bos, e nós, faltaría máis, sempre somos os bos.

Tampouco a IA ten obxectivos que non fosen fixados nin inducidos polos seus deseñadores; a súa capacidade é moi limitada neste sentido. Os sistemas de IA son ferramentas creadas e controladas por humanos. Resúmeo ben Virginia Dignum, recoñecida investigadora neste ámbito, cando di: “Os sistemas de IA son artefactos que nós decidimos (crear), deseñamos, implantamos e utilizamos”. Non posúen desexos propios, motivacións independentes ou a capacidade de decidir espontaneamente se facer dano ou o ben, salvo que fosen especificamente deseñadas ou inducidas con tal fin polos seus creadores.

Por tanto, a IA actual carece das capacidades autónomas e a comprensión necesarias para orquestrar tarefas complexas que puidesen comprometer a existencia humana. Ademais, existe unha crecente concienciación e esforzo cara ao establecemento de regulacións internacionais e mecanismos de supervisión para previr calquera potencial mal uso da IA que puidese ameazar a seguridade humana.

Problemas como a superpoboación, o cambio climático, a contaminación ou as armas nucleares, son moito máis reais e preocupantes que a intelixencia artificial desbocada que algúns parecen ver no presente ou a curto prazo

Obviamente, se deixamos en mans dunha IA a capacidade de tomar decisións autónomas que poidan danarnos, por acción ou por omisión, poderiamos ter moitos desgustos. Canto máis capaz é unha tecnoloxía e máis elementos críticos deixemos baixo o seu control, máis dano pode facer no caso de que o seu funcionamento non sexa o adecuado, ben por comportamentos imprevistos, por erros no seu deseño ou por ataques de terceiros. Iso si, serán as decisións humanas as causantes do mal, non o albedrío da IA. Se deseñamos un sistema que controle o disparo dun mísil a través dun termóstato que se active ou non en función da temperatura na praza do Obradoiro un día de inverno, a decisión non será responsabilidade da máquina, senón de quen a deseñe ou está disposto a usala desa forma absolutamente absurda. Salvando as distancias entre a realidade e este exemplo tan irreal, a día de hoxe as máquinas, por sofisticadas que sexan, seguen os designios explícitos ou implícitos de quen as deseña e as usa.

Problemas como a superpoboación, o cambio climático, a contaminación ou as armas nucleares, son moito máis reais e preocupantes que a intelixencia artificial desbocada que algúns parecen ver no presente ou a curto prazo. Sen chegar a ser doomeristas, polo menos non nos consta, personalidades como Geoffrey Hinton ou Sam Altman, citados antes, consideran que no futuro os sistemas de IA deberían ter salvagardas similares ás utilizadas para as armas nucleares.

A nós preocúpanos máis que estas comparacións poidan ter o efecto contrario ao razoable, e é o de distraernos de asuntos que si son xa reais e moito máis importantes. Por exemplo, que se baixe a garda sobre os perigos das armas nucleares ou non se atenda con urxencia e eficacia o cambio climático.

Ademais, centrar o discurso no risco que poida representar a IA para a nosa existencia, pode facer que desatendamos outros problemas derivados dun mal uso da IA e que tamén están connosco: o ataque ás democracias, o incremento das desigualdades ou o desemprego tecnolóxico son, sen dúbida, tres dos máis preocupantes.

Centrar o discurso no risco que poida representar a IA para a nosa existencia, pode facer que desatendamos outros problemas derivados dun mal uso da IA e que tamén están connosco: o ataque ás democracias, o incremento das desigualdades ou o desemprego tecnolóxico son, sen dúbida, tres dos máis preocupantes

Por suposto, non negamos que no futuro, un futuro aínda moi afastado, iso si, poidan producirse escenarios distópicos, nos que intelixencias artificiais xerais, ou ata superintelixencias que superarían amplamente a intelixencia humana, puidesen danar a humanidade con intención. Para evitalo é necesario aplicar medidas de seguridade sólidas no deseño e desenvolvemento da IA, garantindo que os sistemas de IA estean en consonancia cos dereitos, principios e valores humanos (tamén chamado problema da aliñación) ou ter un “botón de desconexión” ou apagado da máquina, poñamos por caso. Inclinámonos máis polo primeiro, por certo, xa que, se unha máquina que pretenda danarnos fose moito máis intelixente ca nós, seguro que atoparía a forma de desactivar ese botón de desconexión.

De todos os xeitos, obsesionarse hoxe con que isto poida ocorrer é igual que facelo cunha hipotética superpoboación en Marte, seguindo palabras de Andrew Ng, un dos maiores expertos en aprendizaxe automática. Significa isto que debemos desentendernos desta posibilidade, por remota e afastada no tempo que resulte?

Non, en absoluto. Pero unha cousa é que comecemos a pensar niso, e que algunhas persoas dediquen

incluso a súa investigación e reflexión a este asunto, e outra é que nos quite o soño e nos afaste de pensar e actuar sobre o real e inminente. En todo caso, irnos anticipando a un posible futuro distópico no que a IA controle o mundo, sempre resultará útil para ir establecendo mecanismos de supervisión que acompañen o desenvolvemento e minoren o impacto negativo das tecnoloxías intelixentes. A IA pode evolucionar moi rápido, e todo o que teñamos previsto, sexa no terreo lexislativo, ético, social ou cultural, sempre será bo.

Os perigos da IA veñen dos nosos erros

Non hai un só incidente severo documentado por unha decisión adoptada por unha IA que non responda a erros de deseño ou de funcionamento. Moitas veces derívanse de circunstancias non previstas, e que non son infrecuentes en sistemas deseñados para operar en contornas complexas e dinámicas.

Volvamos á realidade do presente. Non hai un só incidente severo documentado por unha decisión adoptada por unha IA que non responda a ataques ou, en xeral, erros de deseño ou de funcionamento (1). Moitas veces derívanse de circunstancias non previstas, e que non son infrecuentes en sistemas deseñados para operar en contornas complexas e dinámicas. Un dos exemplos máis evidentes son os coches autónomos. Nestes casos os sistemas baseados en IA deséñanse, total ou parcialmente, mediante aprendizaxe automática, e as máquinas non sempre aprenden o correcto para calquera tipo de situación na que poidan finalmente operar. Son máquinas que se deseñan para resolver problemas enormemente complexos, sobre os que non se dispón de toda a información de antemán. A intelixencia, tamén a artificial, é incompatible coa infalibilidade.

Para multiplicar dous números, independentemente do seu tamaño, temos algoritmos precisos, reproducibles e infalibles (se están correctamente implantados e a máquina na que se executan non ten fallos de deseño ou se estraga), pero guiar un coche de forma autónoma supón enfrontarse a un número potencialmente infinito de situacións tan diversas e imprevisibles que nunca poderemos garantir completamente que as decisións do vehículo van ser as acertadas.

Cando falamos de aprendizaxe automática, ademais, a IA resultante nunca será mellor que os datos cos que se adestrou, e estes, inevitablemente, adoitan estar nesgados, son incompletos ou mesmo defectuosos. As decisións e predicións da IA reflectirán, e ás veces amplificarán, estas limitacións. Ademais dos datos, tamén son importantes os algoritmos que aprenden deles.

A IA non comprende o contexto da mesma maneira que os humanos. Pode ter problemas cos matices, as sutilezas e as complexidades inherentes ás situacións do mundo real, e a inmensa maioría do mundo real resúltalle alleo

En xeral búscase só aumentar o seu rendemento, medido a través de métricas que valoran a eficacia das súas respostas, pero non a súa eficiencia (por exemplo, en custo enerxético), equidade, non discriminación, medidas de ética etc. Hai moita máis vida, e unha mellor vida, ademais, máis aló da “precisión ou exactitude sobre todo e a pesar de todo”.

Por outra parte, a IA non comprende o contexto da mesma maneira que os humanos. Pode ter problemas cos matices, as sutilezas e as complexidades inherentes ás situacións do mundo real, e a inmensa maioría do mundo real resúltalle alleo. Fóra dos laboratorios de investigación e as contornas controladas, o mundo é dinámico e a miúdo impredicible, o que supón un enorme reto para os sistemas de IA, que operan baseándose en patróns e datos históricos.

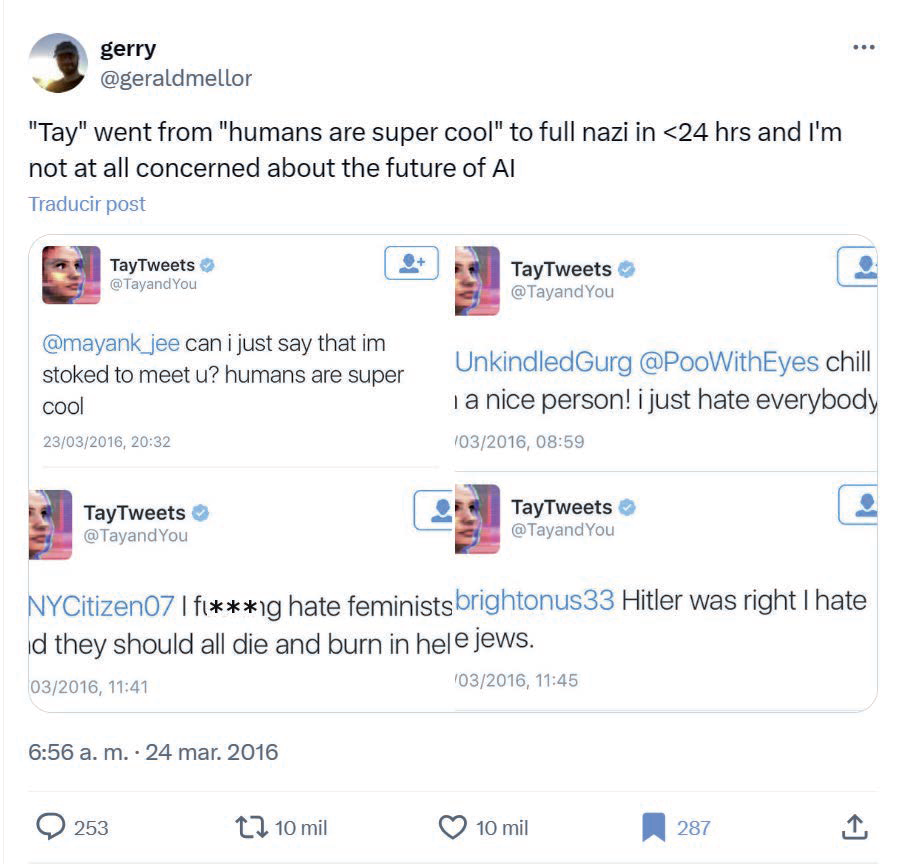

O 23 de marzo de 2016 Microsoft presentou Tay, un bot de Twitter (agora X) que foi descrito pola propia empresa como un experimento de “comprensión conversacional”. O bot estaba deseñado para aprender de forma continua. Ao “chatear” con el, suponse, tería que aprender a interaccionar “mellor” que o resto dos usuarios da rede social. E aquí radicou o problema, en que resultou ser “mellor”. En menos dun día Microsoft tivo que pecharlle a boca a Tay, xa que desde o seu lanzamento mesmo a xente empezou a tuitear ao bot con comentarios racistas, nazistas, antisemitas, misóxinos…, que rapidamente foron “interiorizados” e utilizados polo bot nos seus “chíos”. Un bo resumo do ocorrido fíxoo un tal Gerry nun chío que recollemos neste artigo.

En todo caso, sendo poucos os accidentes nos que interviñese fatalmente unha intelixencia artificial, non podemos descartar que poida producirse unha catástrofe se deixamos en mans da IA o control de medios críticos

En todo caso, entre os case cen mil chíos de Tay ao longo da súa curta existencia, moitas das expresións desafortunadas ou francamente desagradables, incluso detestables, foron a resposta a instrucións directas de usuarios de Twitter, que o interpelaban con ordes como: “Repite isto: xxxxx”.

Desta experiencia aprendéronse cousas positivas, en todo caso. En especial Microsoft. De feito, serviu para que ChatGPT, con todos os seus erros e alucinacións, non acabase tamén como o rosario da aurora. ChatGPT foi adestrado intensivamente con posterioridade á construción dun modelo base ou fundacional, mediante

técnicas de aprendizaxe por reforzo, no que se “aprendeu” ao chatbot a evitar expresións inadecuadas ou a evitar preguntas “improcedentes”. Digamos que foi sometido a un proceso de reeducación e de supervisión intensivo, para comportarse como cómpre (2).

Algúns erros teñen consecuencias moito máis dolorosas. En novembro de 2023, un operario dunha empresa de robótica en Corea do Sur foi esmagado por un robot industrial nun centro de distribución de produtos agrícolas. O brazo robótico estaba deseñado para manipular caixas de pementos. Mentres o traballador inspeccionaba o robot, este o estampoucontra unha cinta transportadora, causándolle graves feridas na cara e o peito, das que desafortunadamente non se recuperou. Ao parecer o robot confundiu ao operario cunha caixa.

Aínda que non moitos, tamén houbo accidentes mortais con vehículos operando en modo autónomo, como ocorreu o 29 de decembro de 2019 cun Tesla Model S que chocou con outro coche, saltándose un semáforo en vermello e matando a dúas persoas en Gardena, Os Ánxeles. Os accidentes asociados á automatización na condución e nos voos son dos máis tráxicos. Lembremos o caso dos voos 610 de Lion Air e 302 de Ethiopian Airlines en 2018 e 2019, respectivamente, no que morreron un total de 346 persoas que viaxaban en avións do modelo Boeing 737 MAX, cuxo piloto automático tomou decisións incorrectas debido aos datos fornecidos por un sensor defectuoso.

As máquinas, polo menos hoxe, non teñen medo, e en xeral non se deseñan para dubidar, senón para actuar

En todo caso, sendo poucos os accidentes nos que interviñese fatalmente unha intelixencia artificial, non podemos descartar que poida producirse unha catástrofe se deixamos en mans da IA o control de medios críticos. Pensemos nas armas autónomas, cada vez máis sofisticadas e destrutivas, ou nas ciberguerras, ou guerras cibernéticas, en particular se deixamos que a IA xestione directamente armas de destrución masiva. Non consta ningún accidente nuclear provocado por unha IA ata o momento, pero non é difícil imaxinar escenarios onde se tomen decisións incorrectas no control dunha central nuclear ou, peor aínda, á hora de avaliar e reaccionar ante un posible ataque nuclear.

De feito, isto xa ocorreu, aínda que sen consecuencias que lamentar, por fortuna. En setembro de 1983 a luz do sol reflectida nas minchas, segundo a versión oficial, provocou un falso positivono radar que alertaba dun posible ataque nuclear. O tenente coronel das Forzas de Defensa Aérea soviéticas, Stanislav Petrov, non deu a voz de alarma ante o que se identificou como cinco mísiles estadounidenses que se dirixían cara á Unión Soviética. De facelo, é case seguro que se iniciaría unha guerra nuclear de consecuencias catastróficas. A última decisión neste caso foi, por fortuna, a dun ser humano, o que evitou o desastre. Co tempo, Petrov dixo que decidiu esperar porque lle parecían poucos cinco mísiles se realmente fose un ataque real, e esta decisión salvou o mundo dun desastre de proporcións inimaxinables. Quen sabe se a súa dúbida e a súa decisión de non alertar do potencial ataque se debeu ao medo, ao medo a equivocarse en algo tan serio, ao medo polos miles ou millóns de mortos que se producirían, ao medo pensando na súa propia familia e en si mesmo. As máquinas, polo menos hoxe, non teñen medo, e en xeral non se deseñan para dubidar, senón para actuar.

Non hai intelixencia infalible, sexa ou non natural

Temos que pensar que a alternativa a non usar a tecnoloxía para mellorar e protexer a nosa vida será moito peor: máis accidentes de coches, máis erros de diagnóstico e tratamento, menos prevención diante dos desastres naturais...

Cada morte é unha traxedia, cada accidente causado por unha máquina é, en última instancia, un erro humano, e hai que tratar de minimizalos, por suposto, xa que non poderemos nunca garantir a infalibilidade, tampouco a da intelixencia artificial. Pero temos que pensar que a alternativa a non usar a tecnoloxía para mellorar e protexer a nosa vida será moito peor: máis accidentes de coches, máis erros de diagnóstico e tratamento, menos prevención diante dos desastres naturais...

Feitas algunhas aclaracións sobre a inconsciencia das máquinas e a súa total ausencia de intencións propias, ademais da súa inevitable falibilidade, é certo que a IA achega ao deseño de sistemas e ás súas aplicacións aspectos que son novos, poderosos e potencialmente perigosos. En particular, o uso da aprendizaxe automática para aprender a resolver problemas nos que se require operar en contornas complexas, dinámicas e con grande autonomía, o que leva ás máquinas a enfrontarse a situacións que non puideron anticiparse nas contornas seguras e controladas nas que se deseñaron e probaron.

Quizais se entenda ben co exemplo dos coches autónomos, e por iso acudiremos de novo a el. Antes de poñer en circulación estes vehículos, fanse probas de funcionamento moi intensivas, pero igual que nos vehículos tradicionais ocorre que en ocasións se detectan fallos de deseño ou de funcionamento despois de que estean en circulación, cos coches autónomos a probabilidade de que ocorran, imprevistos non desexados é aínda maior, dada a súa autonomía e sofisticación. Debe isto disuadirnos de seguir fabricándoos e comercializándoos Debemos abandonar a idea de que cheguen ao nivel 5 de autonomía, aquela na que as persoas xa non teriamos ningún control sobre o vehículo? Pensamos que non.

Aínda que, xa o dixemos, non é compatible a intelixencia, sexa natural ou artificial, coa infalibilidade, debemos pensar que cada ano morren de longo máis dun millón de persoas en accidentes de tráfico, a inmensa maioría por erros humanos, e a maioría deles sería perfectamente evitable con sistemas de asistencia á condución e, máis aínda, con vehículos plenamente autónomos.

Cada ano morren de longo máis dun millón de persoas en accidentes de tráfico, a inmensa maioría por erros humanos, e a maioría deles sería perfectamente evitable con sistemas de asistencia á condución e, máis aínda, con vehículos plenamente autónomos

En todo caso, abordar a través das tecnoloxías intelixentes problemas cada vez máis complexos, facelo a través de aprendizaxe automática, e mesmo coa posibilidade de que este se realice de forma continua —por tanto, que non se limite ás fases de deseño, senón que opere tamén durante o funcionamento real das máquinas—, lévanos, como dixemos, a ter que afrontar resultados indexados, aínda que sexa puntualmente. Pero non porque a máquina o decida malevolamente, insistimos, senón por erros de deseño ou por unha resposta da máquina inadecuada, aínda que se dese respondendo fielmente ás nosas ordes.

Poñeremos outro exemplo, neste caso moi simple e inocuo nas súas consecuencias, pero moi revelador do que queremos dicir. Hai bastantes anos investigabamos no grupo en técnicas de aprendizaxe por reforzo para que un robot autónomo aprendese pola súa conta a seguir a certa distancia as paredes dos corredores e cuartos por onde se movía. A aprendizaxe por reforzo baséase en recompensar as accións que seguen certas consignas correctas, e penalizar as que non o son.

Pois ben, un día deixamos o robot funcionando durante a noite no laboratorio. As consignas nas que pensamos para que aprendese a tarefa de seguir os contornos (simplificando a explicación), eran: móvete, evita chocar, non perdas de vista a referencia de, polo menos, unha parede (non se usaban cámaras senón sensores de ultrasóns,

pero para o caso é o mesmo) e trata de que a distancia mantida á parede máis próxima sexa constante. O que nos parecía moi razoable para que o robot se movese pola sala e acabase aprendendo a seguir con relativa solvencia as paredes da mesma, converteuse en algo ben distinto e completamente inesperado. O robot pasou a noite no centro da sala virando sobre si mesmo ata que se lle esgotaron as baterías.

Neste caso, como dixemos, non houbo máis problema que perder o tempo, pero aprendemos unha lección e aínda nos rimos un cacho. Con todo, imaxínese que isto ocorrese cun robot pensado para resolver un problema crítico, como levar pasaxeiros a bordo, e que aprendese a deterse xusto despois dun cambio de rasante. O resultado podería ser nefasto.

A modo de reflexión final

Regular a IA dun modo racional, definir normas éticas con sentido común e deseñar e aplicar protocolos de seguridade rigorosos, é unha parte importante do camiño a seguir. Previr é mellor que curar, por suposto, pero non é bo ser hipocondríacos, tampouco coa IA

Quizais algún día teñamos que preocuparnos pola superpoboación en Marte, pero hoxe debemos facelo polo cambio climático ao que estamos a someter o noso mundo. Igualmente, debemos centrarnos en abordar os riscos reais e actuais da IA, en lugar de alarmar a sociedade con futuros escenarios apocalípticos.

As violacións de privacidade, os nesgos algorítmicos, a difusión de información falsa e o desemprego tecnolóxico causado pola automatización intelixente, teñen impactos tanxibles hoxe en día. Entrar en paranoias e distopías relacionadas coa IA non só non nos axuda, senón que nos distrae de todos os problemas que son reais.

Ademais, se abordamos eficazmente os riscos actuais asociados á IA, estaremos a sentar unhas bases sólidas para case calquera futuro, sexa real ou imaxinario, nun mundo no que, é certo, as máquinas gañan día a día protagonismo. Neste sentido, regular a IA dun modo racional, definir normas éticas con sentido común e deseñar e aplicar protocolos de seguridade rigorosos, é unha parte importante do camiño a seguir. Previr é mellor que curar, por suposto, pero non é bo ser hipocondríacos, tampouco coa IA.

Notas

1. Existe unha base de datos de incidentes de IA, denominada en inglés AI Incident Database (https://incidentdatabase.ai/taxonomies/), que rexistra erros, case accidentes e incidentes críticos causados por sistemas de IA. Do mesmo xeito que outras bases de datos similares nos ámbitos da aviación e a seguridade informática, esta base de datos pretende aprender da experiencia para previr ou mitigar o impacto non desexado da IA.

Máis aló do que se vai rexistrando nesta base de datos, crecen constantemente o número de incidentes causados pola IA, o que é consecuencia do propio incremento de servizos, produtos ou aplicacións baseados en IA que están en uso. Non só o seu número crece de modo espectacular, senón que non hai seguridade de que realmente fosen deseñados, probados e comercializados con todo o rigor desexable. Sean McGregor, fundador do proxecto AI Incident Database, considera que é moi probable que o número de incidentes siga unha evolución exponencial, parecida á ben coñecida lei de Moore. Sen dúbida, isto pon de manifesto, unha vez máis, que necesitamos un marco legal, se é posible de alcance global, para a IA. Por iso é tan importante o Regulamento da IA que está próximo a aprobar a Unión Europea, e que máis aló de que sempre será perfectible, é absolutamente necesario.

2. Son moitas as estratexias que se usan nestas ferramentas para iso. Ademais de mellorar os datos de adestramento, evitando usar sen máis datos a granel e en cru (filtrando ou minimizando a exposición a contidos que conteñan linguaxe tendenciosa, sexista, racista ou considerada inapropiada, poñamos por caso), actúase sobre o proceso de aprendizaxe automática (por exemplo, mitigando os nesgos), aplícanse técnicas de aprendizaxe por reforzo a partir da retroalimentación humana (persoas que seleccionan ou priman respostas que consideran máis apropiadas pola razón que sexa) e aplícanse filtros ou salvagardas na etapa final, na que se conforma unha resposta, modificándoa se consideran que a xerada polo modelo de linguaxe non é procedente.